选择遗忘|线性和二次判别分析

线性判别分析(discriminant_analysis.LinearDiscriminantAnalysis)和二次判别分析(discriminant_analysis.QuadraticDiscriminantAnalysis)是两个经典的分类器 。正如他们名字所描述的那样 , 他们分别代表了线性决策平面和二次决策平面 。

【选择遗忘|线性和二次判别分析】这些分类器十分具有吸引力 , 因为它们可以很容易计算得到闭式解(即解析解) 。 其本身具有多分类的特性 , 在实践中已经被证明很有效 , 而且无需调节超参数 。

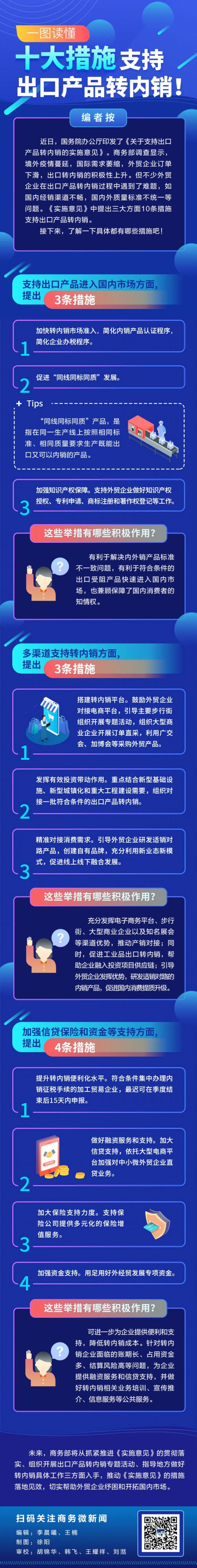

以上这些图像展示了线性判别分析以及二次判别分析的决策边界 。 其中 , 最后一行表明了线性判别分析只能学习线性边界 ,而二次判别分析则可以学习二次边界 , 因此它相对而言更加灵活 。

示例:

Linear and Quadratic Discriminant Analysis with covariance ellipsoid:LDA和QDA在特定数据上的对比

1.2.1. 使用线性判别分析来降维discriminant_analysis.LinearDiscriminantAnalysis 通过把输入的数据投影到由最大化类间分离所组成的线性子空间 , 来执行有监督降维(详细的内容见下面的数学推导部分) 。 输出的维度必然会比原来的类别数量更少的 。 因此它总体而言是十分强大的降维方式 , 同样也仅仅在多分类环境下才能感觉到 。

实现方式在 discriminant_analysis.LinearDiscriminantAnalysis.transform 中 。 关于维度的数量可以通过 n_components 参数来调节 。值得注意的是 , 这个参数不会对 discriminant_analysis.LinearDiscriminantAnalysis.fit 或者 discriminant_analysis.LinearDiscriminantAnalysis.predict 产生影响 。

示例:

Comparison of LDA and PCA 2D projection of Iris dataset: 在 Iris 数据集对比 LDA 和 PCA 之间的降维差异

1.2.2. LDA 和 QDA 分类器的数学公式LDA 和 QDA 都是源于简单的概率模型 , 这些模型对于每一个类别

的相关分布

都可以通过贝叶斯定理所获得:

我们选择最大化条件概率的类别

。

更具体地说 , 对于线性以及二次判别分析 ,

被建模成密度多变量高斯分布:

其中的

是特征的数量 。

为了把该模型作为分类器使用 , 我们只需要从训练数据中估计出类的先验概率

推荐阅读

- 地史食堂|未必需要开凿克拉运河,泰国还有第二选择,和新加坡竞争

- 王者MrPoker|到底有多难打?,不会根据局势来选择出装

- 特朗普|最新美国大选民调结果!52%的人选择拜登,领先特朗普10个点

- 行车视线|颜值惊艳 提供两种动力选择,起亚全新K5凯酷将于今日上市

- Java|计算机专业的本科生,该选择学习Java技术体系还是.NET技术体系

- 百二关河|为何选择策反钟会,他真的有复国的可能吗,姜维在蜀汉灭亡后

- 老靳行色|也要从撤离中国,而中不但不生气反而选择谅解,宁愿自损160亿

- 游戏攻略|《我的勇士》世界boss辅助选什么?世界boss辅助选择推荐

- 加拿大必读|领先特朗普10个点,最新美国大选民调结果!52%的人选择拜登

- ZAKER|高净值人群想要规避风险?海外房产或是一个不可多得的选择!