Hudi|жҠҖжңҜе№Іиҙ§ | UberеҹәдәҺApache Hudiжһ„е»әPBзә§ж•°жҚ®ж№–е®һи·ө( дәҢ )

иҜ»ж—¶еҗҲ并表зұ»еһӢдҪҝз”ЁеҲ—ејҸпјҲдҫӢеҰӮApache Parquetпјүе’ҢеҹәдәҺиЎҢпјҲдҫӢеҰӮApache Avroпјүж–Үд»¶ж јејҸзҡ„з»„еҗҲжқҘеӯҳеӮЁж•°жҚ® гҖӮ жӣҙж–°и®°еҪ•еҲ°еўһйҮҸж–Ү件дёӯ пјҢ 然еҗҺд»ҘеҗҢжӯҘжҲ–ејӮжӯҘеҺӢзј©ж–№ејҸз”ҹжҲҗеҲ—ж–Ү件зҡ„ж–°зүҲжң¬ гҖӮ

Hudiиҝҳж”ҜжҢҒдёӨз§ҚжҹҘиҜўзұ»еһӢпјҡеҝ«з…§жҹҘиҜўе’ҢеўһйҮҸжҹҘиҜў гҖӮ еҝ«з…§жҹҘиҜўжҳҜд»Һз»ҷе®ҡзҡ„жҸҗдәӨжҲ–еҺӢзј©ж“ҚдҪңејҖе§ӢеҜ№иЎЁиҝӣиЎҢ"еҝ«з…§"зҡ„иҜ·жұӮ гҖӮ еҲ©з”Ёеҝ«з…§жҹҘиҜўж—¶ пјҢ еҶҷж—¶еӨҚеҲ¶иЎЁзұ»еһӢд»…жҡҙйңІжңҖж–°ж–Ү件зүҮдёӯзҡ„еҹәжң¬/еҲ—ж–Ү件 пјҢ 并且дёҺйқһHudiиЎЁзӣёжҜ” пјҢ еҸҜдҝқиҜҒзӣёеҗҢзҡ„еҲ—жҹҘиҜўжҖ§иғҪ гҖӮ еҶҷе…Ҙж—¶еӨҚеҲ¶жҸҗдҫӣдәҶзҺ°жңүParquetиЎЁзҡ„жӣҝд»Је“Ғ пјҢ еҗҢж—¶жҸҗдҫӣдәҶupsert/deleteе’Ңе…¶д»–еҠҹиғҪ гҖӮ еҜ№дәҺиҜ»ж—¶еҗҲ并表 пјҢ еҝ«з…§жҹҘиҜўйҖҡиҝҮеҠЁжҖҒеҗҲ并жңҖж–°ж–Ү件еҲҮзүҮзҡ„еҹәжң¬ж–Ү件е’ҢеўһйҮҸж–Ү件жқҘжҸҗдҫӣиҝ‘д№Һе®һж—¶зҡ„ж•°жҚ®пјҲеҲҶй’ҹзә§пјү гҖӮ еҜ№дәҺеҶҷж—¶еӨҚеҲ¶иЎЁ пјҢ иҮӘз»ҷе®ҡжҸҗдәӨжҲ–еҺӢзј©д»ҘжқҘ пјҢ еўһйҮҸжҹҘиҜўе°ҶжҸҗдҫӣеҶҷе…ҘиЎЁзҡ„ж–°ж•°жҚ® пјҢ 并жҸҗдҫӣжӣҙж”№жөҒд»ҘеҗҜз”ЁеўһйҮҸж•°жҚ®з®ЎйҒ“ гҖӮ

3. Apache HudiеңЁUberзҡ„дҪҝз”Ё

еңЁUberеҗ„з§ҚеңәжҷҜдёӯйғҪдҪҝз”ЁеҲ°дәҶHudi пјҢ д»ҺеңЁUberе№іеҸ°дёҠжҸҗдҫӣжңүе…іиЎҢзЁӢзҡ„еҝ«йҖҹгҖҒеҮҶзЎ®зҡ„ж•°жҚ® пјҢ д»ҺжЈҖжөӢж¬әиҜҲеҲ°еңЁUber Eatsе№іеҸ°дёҠжҸҗдҫӣйӨҗеҺ…е’ҢзҫҺйЈҹжҺЁиҚҗ гҖӮ дёәдәҶжј”зӨәHudiзҡ„е·ҘдҪңеҺҹзҗҶ пјҢ и®©е…¶йҖҗжӯҘдәҶи§ЈеҰӮдҪ•зЎ®дҝқUber Marketplaceдёӯзҡ„иЎҢзЁӢж•°жҚ®еңЁж•°жҚ®ж№–дёҠжҳҜжңҖж–°зҡ„ пјҢ д»ҺиҖҢж”№е–„Uberе№іеҸ°дёҠзҡ„йӘ‘жүӢе’Ңй©ҫ驶е‘ҳзҡ„з”ЁжҲ·дҪ“йӘҢ гҖӮ иЎҢзЁӢзҡ„е…ёеһӢз”ҹе‘Ҫе‘Ёжңҹе§ӢдәҺйӘ‘жүӢжҸҗеҮәзҡ„иЎҢзЁӢ пјҢ 然еҗҺйҡҸзқҖиЎҢзЁӢзҡ„иҝӣиЎҢиҖҢ继з»ӯ пјҢ зӣҙеҲ°иЎҢзЁӢз»“жқҹдё”йӘ‘жүӢеҲ°иҫҫжңҖз»Ҳзӣ®зҡ„ең°ж—¶жүҚз»“жқҹ гҖӮ Uberзҡ„ж ёеҝғиЎҢзЁӢж•°жҚ®д»ҘиЎЁж јеҪўејҸеӯҳеӮЁеңЁUberзҡ„еҸҜжү©еұ•ж•°жҚ®еӯҳеӮЁSchemalessдёӯ гҖӮ иЎҢзЁӢиЎЁдёӯзҡ„еҚ•дёӘиЎҢзЁӢжқЎзӣ®еңЁиЎҢзЁӢзҡ„з”ҹе‘Ҫе‘ЁжңҹдёӯеҸҜиғҪдјҡз»ҸеҺҶи®ёеӨҡжӣҙж–° гҖӮ еңЁUberдҪҝз”ЁHudiд№ӢеүҚ пјҢ еӨ§еһӢApache SparkдҪңдёҡдјҡе®ҡжңҹе°Ҷж•ҙдёӘж•°жҚ®йӣҶйҮҚж–°еҶҷе…ҘHDFS пјҢ д»ҘиҺ·еҸ–дёҠжёёеңЁзәҝиЎЁзҡ„жҸ’е…ҘгҖҒжӣҙж–°е’ҢеҲ йҷӨ пјҢ д»ҺиҖҢеҸҚжҳ еҮәиЎҢзЁӢзҠ¶жҖҒзҡ„еҸҳеҢ– гҖӮ

е°ұиғҢжҷҜиҖҢиЁҖ пјҢ еңЁ2016е№ҙеҲқпјҲеңЁжһ„е»әHudiд№ӢеүҚпјү пјҢ дёҖдәӣжңҖеӨ§зҡ„д»»еҠЎжҳҜдҪҝз”Ё1000дёӘexecutors并еӨ„зҗҶи¶…иҝҮ20TBзҡ„ж•°жҚ® пјҢ жӯӨиҝҮзЁӢдёҚд»…ж•ҲзҺҮдҪҺдёӢ пјҢ иҖҢдё”йҡҫд»Ҙжү©еұ• гҖӮ е…¬еҸёзҡ„еҗ„дёӘеӣўйҳҹйғҪдҫқйқ еҝ«йҖҹгҖҒеҮҶзЎ®зҡ„ж•°жҚ®еҲҶжһҗжқҘжҸҗдҫӣй«ҳиҙЁйҮҸзҡ„з”ЁжҲ·дҪ“йӘҢ пјҢ дёәж»Ўи¶іиҝҷдәӣиҰҒжұӮ пјҢ UberеҪ“еүҚзҡ„и§ЈеҶіж–№жЎҲж— жі•жү©еұ•иҝӣиЎҢж•°жҚ®ж№–дёҠзҡ„еўһйҮҸеӨ„зҗҶ гҖӮ дҪҝз”Ёеҝ«з…§е’ҢйҮҚж–°еҠ иҪҪи§ЈеҶіж–№жЎҲе°Ҷж•°жҚ®з§»иҮіHDFSж—¶ пјҢ иҝҷдәӣдҪҺж•ҲзҺҮзҡ„еӨ„зҗҶжӯЈеңЁеҶҷеҲ°еҲ°жүҖжңүж•°жҚ®з®ЎйҒ“ пјҢ еҢ…жӢ¬дҪҝз”ЁжӯӨеҺҹе§Ӣж•°жҚ®зҡ„дёӢжёёETL пјҢ еҸҜд»ҘзңӢеҲ°иҝҷдәӣй—®йўҳеҸӘдјҡйҡҸзқҖ规模зҡ„жү©еӨ§иҖҢеҠ еү§ гҖӮ

еңЁжІЎжңүе…¶д»–еҸҜиЎҢзҡ„ејҖжәҗи§ЈеҶіж–№жЎҲеҸҜдҫӣдҪҝз”Ёзҡ„жғ…еҶөдёӢ пјҢ UberдәҺ2016е№ҙжң«дёәUberжһ„е»ә并еҗҜеҠЁдәҶHudi пјҢ д»Ҙжһ„е»әеҸҜдҝғиҝӣеӨ§и§„жЁЎеҝ«йҖҹ пјҢ еҸҜйқ ж•°жҚ®жӣҙж–°зҡ„дәӢеҠЎжҖ§ж•°жҚ®ж№– гҖӮ Uberзҡ„第дёҖд»ЈHudiеҲ©з”ЁдәҶеҶҷж—¶еӨҚеҲ¶иЎЁзұ»еһӢ пјҢ иҜҘиЎЁзұ»еһӢжҜҸ30еҲҶй’ҹе°ҶдҪңдёҡеӨ„зҗҶйҖҹеәҰжҸҗй«ҳеҲ°20GB пјҢ I/Oе’ҢеҶҷе…Ҙж”ҫеӨ§еҮҸе°‘дәҶ100еҖҚ гҖӮ еҲ°2017е№ҙеә• пјҢ Uberзҡ„жүҖжңүеҺҹе§Ӣж•°жҚ®иЎЁйғҪйҮҮз”ЁдәҶHudiж јејҸ пјҢ иҝҗиЎҢзқҖең°зҗғдёҠжңҖеӨ§зҡ„дәӢеҠЎж•°жҚ®ж№–д№ӢдёҖ гҖӮ

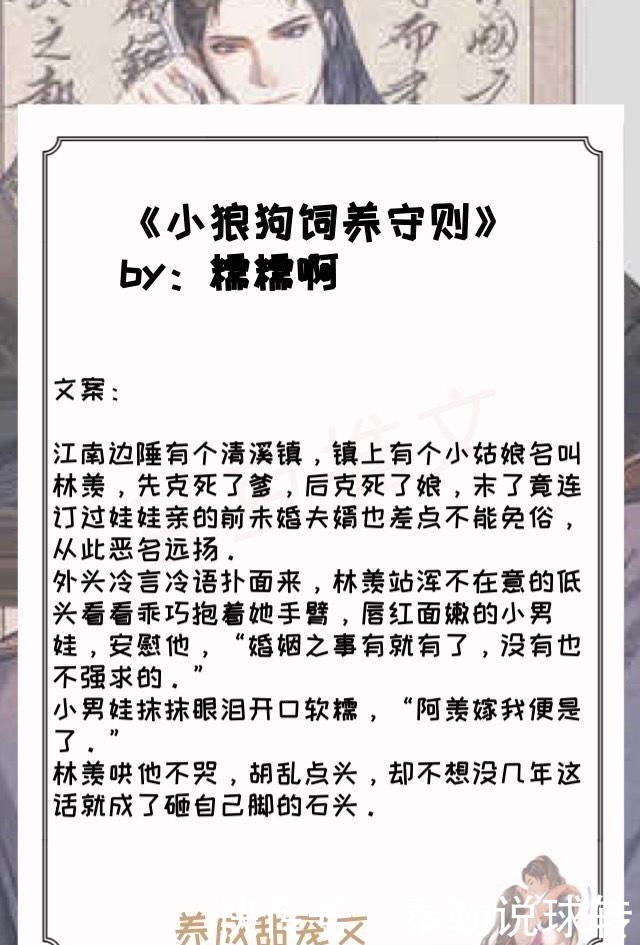

жң¬ж–ҮжҸ’еӣҫ

еӣҫ2. Hudiзҡ„еҶҷж—¶еӨҚеҲ¶еҠҹиғҪдҪҝжҲ‘们иғҪеӨҹжү§иЎҢж–Ү件зә§жӣҙж–° пјҢ д»ҺиҖҢеӨ§еӨ§жҸҗй«ҳж•°жҚ®зҡ„ж–°йІңеәҰ

4. ж”№иҝӣApache Hudi

йҡҸзқҖUberж•°жҚ®еӨ„зҗҶе’ҢеӯҳеӮЁйңҖжұӮзҡ„еўһй•ҝ пјҢ UberејҖе§ӢйҒҮеҲ°Hudiзҡ„еҶҷж—¶еӨҚеҲ¶еҠҹиғҪзҡ„еұҖйҷҗжҖ§ пјҢ дё»иҰҒжҳҜйңҖиҰҒ继з»ӯжҸҗй«ҳж•°жҚ®зҡ„еӨ„зҗҶйҖҹеәҰе’Ңж–°йІңеәҰ пјҢ еҚідҪҝдҪҝз”ЁHudi"еҶҷж—¶еӨҚеҲ¶"еҠҹиғҪ пјҢ Uberзҡ„жҹҗдәӣ表收еҲ°зҡ„жӣҙж–°д№ҹеҲҶж•ЈеңЁ90пј…зҡ„ж–Ү件дёӯ пјҢ д»ҺиҖҢеҜјиҮҙйңҖиҰҒйҮҚеҶҷж•°жҚ®ж№–дёӯд»»дҪ•з»ҷе®ҡзҡ„еӨ§еһӢиЎЁзҡ„ж•°жҚ® пјҢ йҮҚеҶҷж•°жҚ®йҮҸеӨ§зәҰдёә100TB гҖӮ з”ұдәҺеҶҷж—¶еӨҚеҲ¶з”ҡиҮідёәеҚ•дёӘдҝ®ж”№зҡ„и®°еҪ•йҮҚеҶҷж•ҙдёӘж–Ү件 пјҢ еӣ жӯӨеҶҷеӨҚеҲ¶еҠҹиғҪеҜјиҮҙиҫғй«ҳзҡ„еҶҷж”ҫеӨ§е’ҢжҚҹе®ізҡ„ж–°йІңеәҰ пјҢ д»ҺиҖҢеҜјиҮҙHDFSзҫӨйӣҶдёҠдёҚеҝ…иҰҒзҡ„I/Oд»ҘеҸҠжӣҙеҝ«ең°ж¶ҲиҖ—зЈҒзӣҳз©әй—ҙ пјҢ жӯӨеӨ– пјҢ жӣҙеӨҡзҡ„ж•°жҚ®иЎЁжӣҙж–°ж„Ҹе‘ізқҖжӣҙеӨҡзҡ„ж–Ү件зүҲжң¬ пјҢ д»ҘеҸҠHDFSж–Ү件数йҮҸжҝҖеўһ пјҢ еҸҚиҝҮжқҘ пјҢ иҝҷдәӣйңҖжұӮеҜјиҮҙHDFS NamenodeиҠӮзӮ№дёҚзЁіе®ҡе’Ңиҫғй«ҳзҡ„и®Ўз®—жҲҗжң¬ гҖӮ

дёәдәҶи§ЈеҶіиҝҷдәӣж—ҘзӣҠеўһй•ҝзҡ„жӢ…еҝ§ пјҢ Uberе®һзҺ°дәҶ第дәҢз§ҚиЎЁзұ»еһӢ пјҢ еҚі"иҜ»ж—¶еҗҲ并" гҖӮ з”ұдәҺиҜ»ж—¶еҗҲ并йҖҡиҝҮеҠЁжҖҒеҗҲ并数жҚ®жқҘдҪҝз”Ёиҝ‘е®һж—¶зҡ„ж•°жҚ® пјҢ дёәйҒҝе…ҚжҹҘиҜўз«Ҝзҡ„и®Ўз®—жҲҗжң¬ пјҢ йңҖиҰҒеҗҲзҗҶдҪҝз”ЁжӯӨжЁЎејҸ гҖӮ "иҜ»ж—¶еҗҲ并"йғЁзҪІжЁЎеһӢеҢ…жӢ¬дёүдёӘзӢ¬з«Ӣзҡ„дҪңдёҡ пјҢ е…¶дёӯеҢ…жӢ¬дёҖдёӘж‘„еҸ–дҪңдёҡ пјҢ еҢ…жӢ¬з”ұжҸ’е…ҘгҖҒжӣҙж–°е’ҢеҲ йҷӨз»„жҲҗзҡ„ж–°ж•°жҚ® пјҢ дёҖдёӘж¬ЎиҰҒзҡ„еҺӢзј©дҪңдёҡ пјҢ д»ҘејӮжӯҘж–№ејҸдё»еҠЁең°еҺӢзј©е°‘йҮҸжңҖж–°еҲҶеҢәзҡ„жӣҙж–°/еҲ йҷӨеҶ…е®№ пјҢ д»ҘеҸҠдёҖдёӘдё»иҰҒзҡ„еҺӢзј©дҪңдёҡ пјҢ иҜҘдҪңдёҡдјҡзј“ж…ўзЁіе®ҡең°еҺӢзј©еӨ§йҮҸж—§еҲҶеҢәдёӯзҡ„жӣҙж–°/еҲ йҷӨ гҖӮ иҝҷдәӣдҪңдёҡдёӯзҡ„жҜҸдёҖдёӘдҪңдёҡйғҪд»ҘдёҚеҗҢзҡ„йў‘зҺҮиҝҗиЎҢ пјҢ ж¬ЎиҰҒдҪңдёҡе’ҢжҸҗеҸ–дҪңдёҡзҡ„иҝҗиЎҢйў‘зҺҮжҜ”дё»иҰҒдҪңдёҡиҰҒй«ҳ пјҢ д»ҘзЎ®дҝқе…¶жңҖж–°еҲҶеҢәдёӯзҡ„ж•°жҚ®д»ҘеҲ—ж јејҸеҝ«йҖҹеҸҜз”Ё гҖӮ йҖҡиҝҮиҝҷж ·зҡ„йғЁзҪІжЁЎеһӢ пјҢ UberиғҪеӨҹд»ҘеҲ—ејҸдёәж•°еҚғдёӘжҹҘиҜўжҸҗдҫӣж–°йІңж•°жҚ® пјҢ 并е°ҶжҹҘиҜўдҫ§еҗҲ并жҲҗжң¬йҷҗеҲ¶еңЁжңҖиҝ‘зҡ„еҲҶеҢәдёҠ гҖӮ дҪҝз”ЁиҜ»ж—¶еҗҲ并 пјҢ UberиғҪеӨҹи§ЈеҶідёҠйқўжҸҗеҲ°зҡ„жүҖжңүдёүдёӘй—®йўҳ пјҢ 并且HudiиЎЁеҮ д№ҺдёҚеҸ—д»»дҪ•еҜ№ж•°жҚ®ж№–зҡ„жӣҙж–°жҲ–еҲ йҷӨзҡ„еҪұе“Қ гҖӮ зҺ°еңЁ пјҢ еңЁUberеӨ§е®¶дјҡж №жҚ®дёҚеҗҢеңәжҷҜеҗҢж—¶дҪҝз”ЁApache Hudiзҡ„еҶҷж—¶еӨҚеҲ¶е’ҢиҜ»ж—¶еҗҲ并еҠҹиғҪ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- жҠҖжңҜзј–зЁӢ|еҗҺеҸ°жқғйҷҗз®ЎзҗҶи®ҫи®ЎжҖқи·Ҝпјҡдёүз§ҚжЁЎеһӢеҲҶжһҗ

- жҠҖжңҜзј–зЁӢ|еҰӮдҪ•еҲ©з”Ёж•°жҚ®еә“иҝӣиЎҢдё–з•ҢеҸІз ”究

- йқ’е№ҙ|иҘҝе®үйӮ®з”өеӨ§еӯҰдёҺе®үеә·жұүж»ЁеҢәж·ұеәҰеҗҲдҪңпјҢз ”еҸ‘йҖӮеҗҲжҜӣз»’зҺ©е…·е…Ёдә§дёҡй“ҫе®һз”ЁжҠҖжңҜ

- ж— дәә科жҠҖ,з”өжұ жҠҖжңҜ|зӣҳзӮ№еҮ з§Қеёёи§Ғзҡ„ж— дәәжңәз”өжұ

- жҠҖжңҜзј–зЁӢ|ж— жңҚеҠЎеҷЁи°ғз ”пјҢйғЁзҪІREST APIжҳҜжңҖжҷ®йҒҚз”ЁдҫӢ

- дә¬дёң,жҠҳеҸ еұҸжүӢжңә|еӣҙз»•жҹ”жҖ§еұҸзҡ„жҠҖжңҜгҖҒзү№жҖ§гҖҒеә”з”ЁгҖҒдә§дёҡеҢ–иҝӣиЎҢдәҶйқһеёёдё“дёҡзҡ„и§ЈиҜ»

- дә‘и®Ўз®—|и…ҫи®Ҝдә‘е°Ҹеҫ®йҰ–ж¬ЎжҠҖжңҜејҖж”ҫж—ҘпјҢжҸӯз§ҳAIиҜӯйҹіиғҢеҗҺзҡ„еҘҘз§ҳ

- iQOOжүӢжңә|вҖңеҝ«зЁіеҸҢе…ЁвҖқпјҒ120Wи¶…еҝ«й—Әе……жҠҖжңҜзӮ«жҠҖпјҢеҚҒдә”еҲҶй’ҹе……ж»Ўз”өйҮҸ

- й©ұеҠЁдёӯеӣҪ|еӣҪеҶ…йҰ–ж¬Ўеә”з”ЁпјҒж”Ҝд»ҳе®қејҖж”ҫе® зү©йј»зә№иҜҶеҲ«жҠҖжңҜпјҡзҢ«зӢ—йғҪиғҪд№°дҝқйҷ©

- жҠҖжңҜзј–зЁӢ|жңәеҷЁеӯҰд№ еҸҲдёҖйҮҚиҰҒеҢ»еӯҰеә”з”ЁпјҒеҹ№жӨҚдәәйҖ еҷЁе®ҳ