жҳ з»ҙзҪ‘пјҡжҰӮиҝ°и°·жӯҢ Pixel 4 ж·ұеәҰдј ж„ҹ uDepth е·ҘдҪңеҺҹзҗҶе’Ңеә•еұӮз®—жі•

жҹҘзңӢеј•з”Ё/дҝЎжҒҜжәҗиҜ·зӮ№еҮ»пјҡgoogleblog

жҰӮиҝ°uDepthзҡ„е·ҘдҪңеҺҹзҗҶе’Ңеә•еұӮз®—жі•

пјҲжҳ з»ҙзҪ‘2020е№ҙ04жңҲ11ж—ҘпјүзЎ®е®ҡеңәжҷҜдёүз»ҙдҝЎжҒҜзҡ„иғҪеҠӣз§°дёәж·ұеәҰж„ҹжөӢ пјҢ иҝҷеҜ№ејҖеҸ‘иҖ…е’Ңз”ЁжҲ·йғҪжҳҜдёҖйЎ№еҚҒеҲҶжңүд»·еҖјзҡ„е·Ҙе…· гҖӮ ж·ұеәҰдј ж„ҹжҳҜдёҖдёӘйқһеёёжҙ»и·ғзҡ„и®Ўз®—и§Ҷи§үйўҶеҹҹ пјҢ иҝ‘е№ҙжқҘзҡ„еҲӣж–°еҢ…жӢ¬дәәеғҸжЁЎејҸе’ҢARзӯүеә”з”Ё пјҢ д»ҘеҸҠиҜёеҰӮйҖҸжҳҺеҜ№иұЎжЈҖжөӢзӯүеҹәзЎҖж„ҹжөӢеҲӣж–° гҖӮ еҹәдәҺRGBзҡ„еёёи§Ғз«ӢдҪ“ж·ұеәҰдј ж„ҹжҠҖжңҜйңҖиҰҒеҚҒеҲҶй«ҳжҳӮзҡ„и®Ўз®— пјҢ иҖҢдё”еңЁдҪҺзә№зҗҶеҢәеҹҹдјҡеҸ—еҲ°еҪұе“Қ пјҢ 并且еңЁжһҒдҪҺе…үз…§жқЎд»¶дёӢдјҡе®Ңе…ЁеӨұж•Ҳ гҖӮ

еӣ дёәPixel4зҡ„дәәи„ёи§Јй”ҒеҠҹиғҪеҝ…йЎ»д»Ҙй«ҳйҖҹжү§иЎҢ并ж”ҜжҢҒй»‘жҡ—зҺҜеўғ пјҢ жүҖд»Ҙе®ғйңҖиҰҒдёҖз§ҚдёҚеҗҢзҡ„и§ЈеҶіж”ҫе“Ә гҖӮ Pixel4зҡ„еүҚз«ҜеҢ…еҗ«е®һж—¶зәўеӨ–жңүжәҗз«ӢдҪ“ж·ұеәҰдј ж„ҹеҷЁuDepth гҖӮ иҝҷйЎ№жҠҖжңҜжҳҜPixel4зҡ„дёҖйЎ№е…ій”®и®Ўз®—жңәи§Ҷи§үеҠҹиғҪ пјҢ жңүеҠ©дәҺиә«д»ҪйӘҢиҜҒзі»з»ҹиҜҶеҲ«з”ЁжҲ· пјҢ еҗҢж—¶иғҪеӨҹйҳІжӯўж¬әйӘ—ж”»еҮ» гҖӮ еҸҰеӨ– пјҢ е®ғж”ҜжҢҒдёҖзі»еҲ—зҡ„ж–°еҠҹиғҪ пјҢ еҰӮдәӢеҗҺз…§зүҮж¶ҰиүІгҖҒеҹәдәҺж·ұеәҰзҡ„еңәжҷҜеҲҶеүІгҖҒиғҢжҷҜжЁЎзіҠгҖҒдәәеғҸж•Ҳжһңе’Ң3Dз…§зүҮзӯү гҖӮ

и°·жӯҢжңҖиҝ‘д»ҘCamera2APIзҡ„ж–№ејҸжқҘжҸҗдҫӣдәҶuDepthзҡ„и®ҝй—®жқғйҷҗ пјҢ е…Ғи®ёдҪҝз”ЁPixelNeuralCoreгҖҒдёӨдёӘзәўеӨ–ж‘„еғҸеӨҙе’ҢдёҖдёӘзәўеӨ–жЁЎејҸжҠ•еҪұд»Ә并д»Ҙ30HzжҸҗдҫӣж—¶й—ҙеҗҢжӯҘзҡ„ж·ұеәҰеё§ гҖӮ GoogleCameraAppдҪҝз”ЁиҝҷдёӘAPIдёәPixel4з”ЁжҲ·зҡ„иҮӘжӢҚеёҰжқҘдјҳеҢ–зҡ„ж·ұеәҰеҠҹиғҪ гҖӮ еңЁиҝҷзҜҮеҚҡж–Үдёӯ пјҢ и°·жӯҢе°Ҷеҗ‘еӨ§е®¶жҰӮиҰҒи§ЈйҮҠuDepthзҡ„е·ҘдҪңеҺҹзҗҶе’Ңеә•еұӮз®—жі• пјҢ 并用Piexl4зҡ„зӨәдҫӢз»“жһңеҜ№з”ЁдҫӢиҝӣиЎҢи®Ёи®ә гҖӮ дёӢйқўжҳҜжҳ з»ҙзҪ‘зҡ„е…·дҪ“ж•ҙзҗҶпјҡ

1.з«ӢдҪ“ж·ұеәҰж„ҹжөӢзҡ„з»јиҝ°

жүҖжңүз«ӢдҪ“ж‘„еғҸеӨҙзі»з»ҹйғҪдјҡйҮҮз”Ёи§Ҷе·®йҮҚе»әж·ұеәҰ гҖӮ еҜ№дәҺиҝҷз§Қж•Ҳжһң пјҢ дҪ еҸҜд»ҘжіЁи§ҶдёҖдёӘеҜ№иұЎ пјҢ й—ӯеҗҲе·Ұзңј пјҢ 然еҗҺеј ејҖе·Ұзңје№¶й—ӯеҗҲеҸізңј гҖӮ дҪ дјҡеҸ‘зҺ°еҜ№иұЎзҡ„дҪҚзҪ®дјҡеҮәзҺ°з§»еҠЁ пјҢ иҖҢи¶Ҡйқ иҝ‘зҡ„еҜ№иұЎз§»еҠЁеҫ—и¶Ҡеҝ« гҖӮ uDepthжҳҜDenseLocalStereoеҢ№й…ҚжҠҖжңҜ家ж—Ҹзҡ„дёҖе‘ҳ пјҢ е…¶дё»иҰҒжҳҜйҖҡиҝҮи®Ўз®—жқҘдј°и®ЎжҜҸдёӘеғҸзҙ зҡ„и§Ҷе·® гҖӮ жүҖиҝ°жҠҖжңҜдјҡеңЁдёҖдёӘж‘„еғҸеӨҙеҪўжҲҗзҡ„еӣҫеғҸдёӯиҜ„дј°з”ұжҜҸдёӘеғҸзҙ еҢ…еӣҙзҡ„еҢәеҹҹ пјҢ 并е°қиҜ•еңЁз¬¬дәҢдёӘж‘„еғҸеӨҙзҡ„зӣёеә”еӣҫеғҸдёӯеҜ»жүҫзӣёдјјзҡ„еҢәеҹҹ гҖӮ жӯЈзЎ®ж ЎеҮҶеҗҺ пјҢ з”ҹжҲҗзҡ„йҮҚжһ„еұһдәҺеҸҜеәҰйҮҸ пјҢ иҝҷж„Ҹе‘ізқҖе®ғ们表зӨәе®һйҷ…зҡ„зү©зҗҶи·қзҰ» гҖӮ

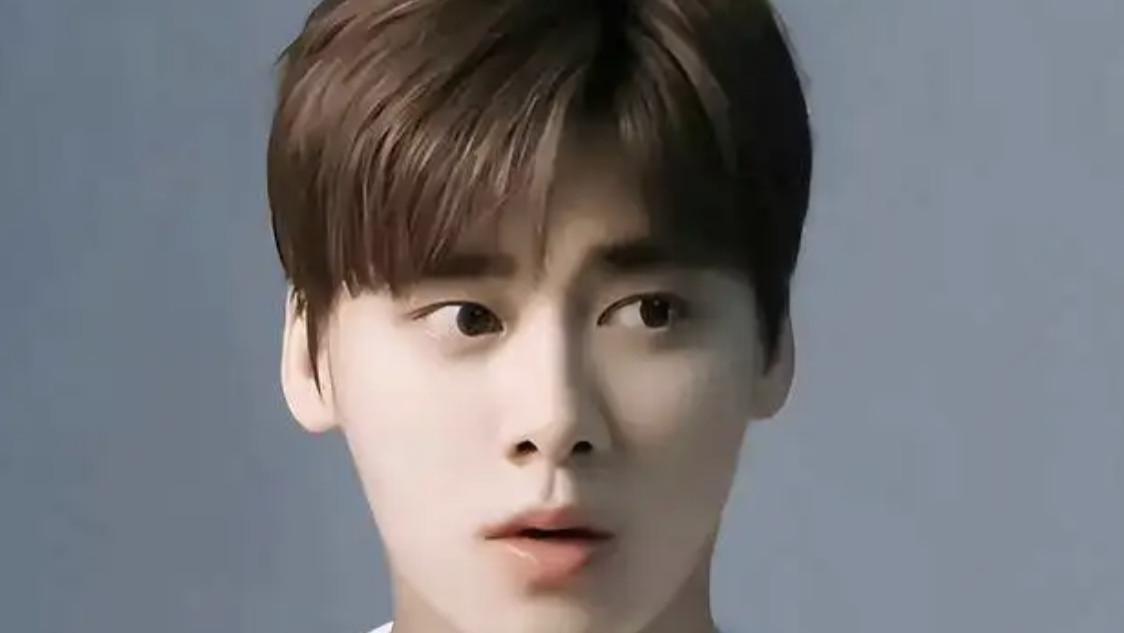

жң¬ж–ҮжҸ’еӣҫ

дёәдәҶеӨ„зҗҶж— зә№зҗҶеҢәеҹҹе’ҢеӨ„зҗҶејұе…үжқЎд»¶ пјҢ еӣўйҳҹдҪҝз”ЁдәҶ"жңүжәҗз«ӢдҪ“"и®ҫзҪ® пјҢ е°ҶзәўеӨ–еӣҫжЎҲжҠ•еҪұеҲ°з”ұз«ӢдҪ“зәўеӨ–ж‘„еӨҙжңәжЈҖжөӢеҲ°зҡ„еңәжҷҜдёӯ гҖӮ жүҖиҝ°ж–№жі•жҸҗй«ҳдәҶдҪҺзә№зҗҶеҢәеҹҹзҡ„еҸҜиҜҶеҲ«жҖ§ пјҢ д»ҺиҖҢдјҳеҢ–дәҶиҜҶеҲ«ж•Ҳжһң并йҷҚдҪҺдәҶзі»з»ҹзҡ„и®Ўз®—йҮҸ гҖӮ

2.uDepthдёҺдј—дёҚеҗҢзҡ„ең°ж–№

з«ӢдҪ“ж„ҹжөӢзі»з»ҹзҡ„иҝҗз®—йҮҸйқһеёёеӨ§ гҖӮ еҜ№дәҺд»Ҙ30Hzйў‘зҺҮиҝҗиЎҢзҡ„ж„ҹжөӢеҷЁ пјҢ е…¶еңЁдҝқжҢҒй«ҳиҙЁйҮҸзҡ„еүҚжҸҗдёӢеҝ…йЎ»жҳҜдҪҺеҠҹиҖ— гҖӮ uDepthеҲ©з”ЁдәҶдј—еӨҡе…ій”®зҡ„и§Ғи§ЈжқҘе®һзҺ°иҝҷдёҖзӮ№ гҖӮ

е…¶дёӯд№ӢдёҖжҳҜ пјҢ з»ҷе®ҡдёҖеҜ№еҪјжӯӨзӣёдјјзҡ„еҢәеҹҹ пјҢ иҖҢеӨ§еӨҡж•°еҜ№еә”зҡ„еӯҗйӣҶеҗҢж ·зӣёдјј гҖӮ дҫӢеҰӮ пјҢ з»ҷе®ҡдёӨдёӘзӣёдјјзҡ„8Г—8еғҸзҙ еқ— пјҢ дёӨиҖ…е·ҰдёҠзҡ„4Г—4еӯҗеҢәеҹҹеҗҢж ·еҸҜиғҪзӣёдјј гҖӮ иҝҷе°Ҷе‘ҠзҹҘuDepthз®ЎйҒ“зҡ„еҲқе§ӢеҢ–иҝҮзЁӢ пјҢ еҗҺиҖ…йҖҡиҝҮжҜ”иҫғжҜҸдёӘеӣҫеғҸдёӯзҡ„йқһйҮҚеҸ еғҸзҙ еқ—并йҖүжӢ©жңҖзӣёдјјзҡ„еғҸзҙ еқ—жқҘжһ„е»әж·ұеәҰе»әи®®йҮ‘еӯ—еЎ” гҖӮ иҝҷдёӘиҝҮзЁӢд»Һ1Г—1еғҸзҙ еқ—ејҖе§Ӣ пјҢ 并жҢүеұӮзҙҜз§Ҝж”ҜжҢҒ пјҢ зӣҙеҲ°з”ҹжҲҗеҲқе§ӢдҪҺеҲҶиҫЁзҺҮж·ұеәҰжҳ е°„ гҖӮ

еңЁеҲқе§ӢеҢ–д№ӢеҗҺ пјҢ еӣўйҳҹеә”з”ЁдёҖз§Қе…Ёж–°зҡ„зҘһз»Ҹж·ұеәҰз»ҶеҢ–жҠҖжңҜжқҘж”ҜжҢҒPixel4зҡ„规еҲҷзҪ‘ж јеӣҫжЎҲз…§жҳҺеҷЁ гҖӮ е…ёеһӢзҡ„жңүжәҗз«ӢдҪ“зі»з»ҹжҠ•е°„дёҖдёӘдјӘйҡҸжңәзҪ‘ж јеӣҫжЎҲжқҘеё®еҠ©ж¶ҲйҷӨеңәжҷҜдёӯзҡ„еҢ№й…Қжӯ§д№ү пјҢ дҪҶuDepthиғҪеӨҹж”ҜжҢҒйҮҚеӨҚзҡ„зҪ‘ж јжЁЎејҸ гҖӮ йҮҚеӨҚз»“жһ„дә§з”ҹзҡ„еҢәеҹҹеңЁз«ӢдҪ“еҜ№дёӯзңӢиө·жқҘеҚҒеҲҶзӣёдјј пјҢ 并еҸҜиғҪеҜјиҮҙдёҚжӯЈзЎ®зҡ„еҢ№й…Қ гҖӮ й’ҲеҜ№иҝҷдёӘй—®йўҳ пјҢ еӣўйҳҹйҮҮз”ЁдәҶиҪ»йҮҸзә§еҚ·з§Ҝжһ¶жһ„ пјҢ йҖҡиҝҮзәўеӨ–дә®еәҰе’ҢйӮ»иҝ‘дҝЎжҒҜжқҘи°ғж•ҙдёҚжӯЈзЎ®зҡ„еҢ№й…Қ пјҢ иҖҢжҜҸеё§иҖ—ж—¶дёҚеҲ°1.5ms гҖӮ

жң¬ж–ҮжҸ’еӣҫ

зҘһз»Ҹж·ұеәҰз»ҶеҢ–жһ¶жһ„

еңЁзҘһз»Ҹж·ұеәҰз»ҶеҢ–д№ӢеҗҺ пјҢ еҗҲйҖӮзҡ„ж·ұеәҰдј°и®Ўе°Ҷд»ҺзӣёйӮ»зҡ„еғҸзҙ еқ—иҝӯд»Јдј ж’ӯ гҖӮ иҝҷдёӘе’ҢеҗҺз»ӯзҡ„з®ЎйҒ“жӯҘйӘӨеҲ©з”ЁдәҶuDepthжҲҗеҠҹзҡ„еҸҰдёҖдёӘе…ій”®жҙһеҜҹпјҡиҮӘ然еңәжҷҜйҖҡеёёжҳҜеұҖйғЁе№ійқў пјҢ еҸӘжңүеҫҲе°Ҹзҡ„йқһе№ійқўеҒҸе·® гҖӮ иҝҷдҪҝеҫ—еӣўйҳҹиғҪеӨҹжүҫеҲ°иҰҶзӣ–еңәжҷҜзҡ„е№ійқўеғҸзҙ еқ— пјҢ 然еҗҺеҸӘдёәдёҖдёӘеғҸзҙ еқ—дёӯзҡ„жҜҸдёӘеғҸзҙ з»ҶеҢ–еҚ•дёӘж·ұеәҰ пјҢ д»ҺиҖҢеӨ§еӨ§еҮҸе°‘и®Ўз®—иҙҹиҪҪ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- гҖҢITд№Ӣ家гҖҚеҜ№ж ҮApple Cardпјҡи°·жӯҢжӢҹжҺЁGoogle CardеҖҹи®°еҚЎ

- еҚҺдёәMate30пјҡеҚҺдёәе®ЈеёғпјҒP40еҹәжң¬е·ІеҺ»и°·жӯҢпјҒеӨ–еӘ’пјҡеҚҺдёәP40еҺ»и°·жӯҢдҫқ然жҳҜйЎ¶зә§ж——иҲ°

- еӨ§еһӢжңә@IBMеҚұйҷ©дәҶпјҒи°·жӯҢдә‘收иҙӯеӨ§еһӢжңәе…¬еҸё

- гҖҢе…ЁеӘ’дҪ“иҒҡз„ҰгҖҚиҰҒе’Ңй«ҳйҖҡиҜҙеҶҚи§ҒдәҶпјҢи°·жӯҢе®ЈеёғдёҖеӨ§ж¶ҲжҒҜпјҢеҚҺдёәеҸҲе°ҶиҝҺжқҘеҜ№жүӢ

- гҖҺи°·жӯҢгҖҸеӨ–жі„и°Қз…§жҳҫзӨәи°·жӯҢжӢҹжҺЁGoogle CardеҖҹи®°еҚЎ

- гҖҺи°·жӯҢгҖҸGoogle Pixel 4зі»еҲ—жүӢжңәеҚіж—Ҙиө·ж”ҜжҢҒеҸҢеҚЎеҸҢеҫ…

- гҖҺдәҡ马йҖҠгҖҸи°·жӯҢгҖҒиӢ№жһңгҖҒдәҡ马йҖҠиҖҒеӨ§еҗҢеӨ©еҸ‘еЈ° еҶҚи°ҲеӨҚе·ҘеӨҚдә§и®ЎеҲ’

- жҳ з»ҙVRв– TeamViewer ARиҝңзЁӢеҚҸдҪңејҖе§Ӣж”ҜжҢҒiPad ProжҝҖе…үйӣ·иҫҫзү№жҖ§

- гҖҢGoogleгҖҚдёәзј“и§Је®ҪеёҰеҺӢеҠӣпјҒи°·жӯҢе°ҶйҷҚдҪҺNestзӣёжңәзҡ„иҙЁйҮҸпјҢдҪҶз”ЁжҲ·еҚҙдёҚд№°иҙҰ

- гҖҺгҖҸи°·жӯҢе’Ңй«ҳйҖҡжҖҘдәҶпјҢиҝһеҝҷејҖеҗҜзүөеҲ¶еҚҺдёәзҡ„вҖңж–°иЎҢеҠЁвҖқ