е’ӢеҪўиұЎзҗҶи§ЈembeddingиҝҷдёӘжҰӮеҝө( дә” )

I2IжҳҜдёҚиҖғиҷ‘дәәзҡ„еӣ зҙ зҡ„пјҢI2IдёҖиҲ¬еә”з”ЁеҲ°д»ҘдёӢеңәжҷҜпјҡ

вҖңжҜ”еҰӮдёҖдёӘдәәе–ңж¬ўд№°еҗ„з§ҚXзұ»еһӢзҡ„жүӢжңәпјҢжҠҠжүҖжңүзү©е“Ғзҡ„EmbeddingпјҢ然еҗҺжүҫи·ҹXзұ»еһӢжүӢжңәи·қзҰ»иҝ‘зҡ„зү©е“ҒжҺЁиҚҗз»ҷиҝҷдёӘдәәеҚіеҸҜвҖқгҖӮжүҖд»ҘI2Iз®—жі•жӣҙеӨҡең°жҳҜиҖғиҷ‘еҰӮдҪ•жұӮзү©е“Ғй—ҙзҡ„зӣёе…іжҖ§пјҢ并表зӨәжҲҗEmbeddingгҖӮ

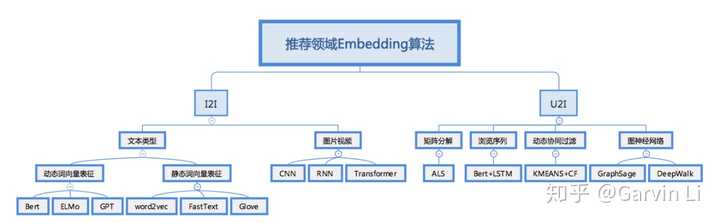

жҲ‘жҠҠI2Iе’ҢU2Iзҡ„жҜ”иҫғжөҒиЎҢзҡ„з®—жі•еҒҡдәҶдёӘжұҮжҖ»пјҢеҰӮдёӢеӣҫпјҡ

I2Iз®—жі•д»Ӣз»Қе…ҲжқҘи®ІI2Iз®—жі•пјҢдёәд»Җд№ҲеҲҶж–Үеӯ—е’ҢеӣҫзүҮдёӨдёӘзұ»зӣ®е‘ўпјҹеӣ дёәе№іж—¶жҲ‘们зңӢеҲ°зҡ„ж–°й—»еӨ§иҮҙжҳҜиҝҷж ·зҡ„пјҡ

?е•Ҷе“ҒеӨ§иҮҙжҳҜиҝҷж ·зҡ„пјҡ

еҫ…жҺЁиҚҗзү©е“ҒйғҪдјҡеҢ…еҗ«еӣҫзүҮе’ҢиҜҙжҳҺж–Үеӯ—пјҢйңҖиҰҒеҗҢж—¶иҖғиҷ‘иҝҷдёӨйғЁеҲҶзҡ„EmbeddingгҖӮ

еӣҫзүҮзұ»еһӢжҜ”иҫғз®ҖеҚ•пјҢдёҖиҲ¬йғҪжҳҜResNetиҝҷдәӣз®—жі•зҡ„дёӯй—ҙеҗ‘йҮҸз»“жһңеҜјеҮәдҪңдёәиҝҷдёӘеӣҫзүҮзҡ„EmbeddingиЎЁзӨәпјҡ

ж–Үжң¬зұ»зҡ„EmbeddingеҸҜд»ҘеҲҶдёәдёӨз§ҚпјҢдёҖз§ҚжҳҜжҜ”иҫғдј з»ҹзҡ„word2vectorгҖҒfasttextгҖҒgloveиҝҷдәӣз®—жі•зҡ„ж–№жЎҲпјҢеҸ«еҒҡиҜҚеҗ‘йҮҸеӣәе®ҡиЎЁеҫҒзұ»з®—жі•пјҢиҝҷдәӣз®—жі•дё»иҰҒжҳҜйҖҡиҝҮеҲҶжһҗиҜҚзҡ„еҮәзҺ°йў‘зҺҮжқҘиҝӣиЎҢEmbeddingз”ҹжҲҗпјҢдёҚиҖғиҷ‘ж–Үжң¬дёҠдёӢж–ҮгҖӮ

иҖҢеҸҰдёҖз§Қж–Үжң¬Embeddingж–№жі•пјҢд№ҹжҳҜзӣ®еүҚжңҖжөҒиЎҢзҡ„ж–№жЎҲжҳҜеҠЁжҖҒиҜҚиЎЁеҫҒз®—жі•пјҢжҜ”еҰӮBertгҖҒELMoгҖҒGPTпјҢиҝҷзұ»з®—жі•дјҡиҖғиҷ‘ж–Үжң¬дёҠдёӢж–ҮгҖӮ

еҠЁжҖҒиҜҚиЎЁеҫҒе’Ңеӣәе®ҡиҜҚиЎЁеҫҒз®—жі•зҡ„еҢәеҲ«еҸҜд»ҘдёҫдёӘдҫӢеӯҗиҜҙжҳҺпјҢжҜ”еҰӮдёӢйқўиҝҷеҸҘиҜқпјҡвҖңе°ҸжҳҺзҲұеҗғиӢ№жһңпјҢд№ҹзҲұдҪҝз”ЁиӢ№жһңжүӢжңәвҖқгҖӮйңҖиҰҒеҜ№вҖңиӢ№жһңвҖқиҝҷдёӘиҜҚеҒҡEmbeddingпјҢеӣәе®ҡиҜҚиЎЁеҫҒз®—жі•еҫҲйҡҫеҢәеҲҶеҮәеҗғзҡ„иӢ№жһңе’ҢжүӢжңәиӢ№жһңе“ҒзүҢпјҢиҖҢеҠЁжҖҒзҡ„иЎЁеҫҒж–№жі•жҳҜеҸҜд»Ҙзҡ„гҖӮ

U2Iз®—жі•1.ALSU2Iз®—жі•еҸҜд»ҘеҲҶдёә4зұ»пјҢжңҖз»Ҹе…ёзҡ„е°ұжҳҜMFзҹ©йҳөеҲҶи§Јз®—жі•ALSпјҢ

жҜ”еҰӮеңЁALSз®—жі•иҫ“е…Ҙзҡ„жҳҜдёӢеӣҫиҝҷж ·зҡ„дәәеҜ№жӯҢзҡ„жү“еҲҶж•°жҚ®пјҢ

?

ALSдјҡж №жҚ®иҝҷж ·зҡ„ж•°жҚ®дә§еҮәдёӨдёӘзҹ©йҳөпјҢиҝҷдёӨдёӘзҹ©йҳөеҲҶеҲ«иЎЁзӨәжҜҸдёӘеҗ¬дј—зҡ„Embeddingе’ҢжҜҸйҰ–жӯҢзҡ„EmbeddingгҖӮ

2.еҹәдәҺжөҸи§ҲеәҸеҲ—EmbeddingеҸҰдёҖз§ҚзӣёеҜ№й«ҳзә§зҡ„дәәзҡ„Embeddingж–№жЎҲжҳҜBert+LSTMпјҢиҝҷзұ»ж–№жЎҲеҸ«жөҸи§ҲеәҸеҲ—Embeddingжі•гҖӮжҲ‘们еҸҜд»ҘжҠҠжҜҸдёӘз”ЁжҲ·еҺҶеҸІзҡ„жөҸи§Ҳи®°еҪ•дҪңдёәиҝҷдёӘдәәзҡ„еұһжҖ§зҡ„иЎЁзӨәгҖӮ

еҒҮи®ҫдёҖдёӘз”ЁжҲ·е…ҲеҗҺжөҸи§ҲиҝҮ3зҜҮж–Үз« пјҢеҲҶеҲ«жҳҜпјҡ

вҖңе·ҙзү№е°”жҺҖзҝ»еҘҘе°је°”вҖқвҖңжҳ“е»әиҒ”жҖ’з Қ3еҲҶпјҢ2зҜ®жқҝвҖқвҖңеӯҷжӮҰзҺҮйўҶж№–дәәеӢҮеӨәжҖ»еҶ еҶӣвҖқйӮЈе°ұеҸҜд»ҘжҠҠиҝҷ3зҜҮж–°й—»ж Үйўҳз”ЁBertеҗ‘йҮҸеҢ–пјҢеҶҚе°Ҷиҝҷдәӣеҗ‘йҮҸжҢүз…§жөҸи§ҲеәҸеҲ—иҫ“е…ҘLSTMпјҢжңҖз»Ҳе°ұз”ҹжҲҗиҝҷдёӘз”ЁжҲ·зҡ„EmbeddingиЎЁзӨәгҖӮ

3.еҠЁжҖҒеҚҸеҗҢиҝҮж»ӨжҺҘзқҖеҶҚд»Ӣз»ҚдёҖз§ҚеҹәдәҺз°ҮзҫӨзҡ„еҚҸеҗҢиҝҮж»ӨеҸ¬еӣһж–№жЎҲпјҢдёҖиҲ¬жҳҜKMEANS+CFгҖӮCFе°ұжҳҜеҚҸеҗҢиҝҮж»Өжі•пјҢеҺҹзҗҶдёҚеӨҡиҜҙдәҶгҖӮиҝҷз§ҚеҸ¬еӣһж–№жЎҲдёҖиҲ¬жҳҜе…Ҳе°ҶжҜҸдёӘз”ЁжҲ·жҢүз…§д»–зҡ„ж ҮзӯҫеҒҡTag EmbeddingпјҢжҜ”еҰӮеҸҜд»ҘжҢүз…§е№ҙйҫ„гҖҒжҖ§еҲ«гҖҒиә«й«ҳеҒҡдёӘEmbeddingгҖӮ

е°ҸжҳҺ=

(29еІҒпјҢ1д»ЈиЎЁз”·жҖ§пјҢиә«й«ҳ180)

然еҗҺз”ЁKMEANSеҒҡжүҖжңүз”ЁжҲ·зҡ„иҮӘеҠЁиҒҡзұ»пјҢжҺҘзқҖй’ҲеҜ№жҜҸдёӘиҒҡзұ»з°ҮеҶ…йғЁзҡ„з”ЁжҲ·еҒҡзӣёдә’д№Ӣй—ҙзҡ„еҚҸеҗҢиҝҮж»ӨпјҢиҝҷж ·еҸҜд»ҘдҝқиҜҒдёәзӣёдјјеҸЈе‘ізҡ„дәәжҺЁйҖҒдә’зӣёйғҪе–ңж¬ўзҡ„зү©е“ҒгҖӮ

4.еӣҫзҘһз»ҸзҪ‘з»ң

еӣҫзҘһз»ҸзҪ‘з»ңEmbeddingжҳҜзӣ®еүҚжҜ”иҫғзғӯй—Ёзҡ„пјҢж•Ҳжһңд№ҹжҳҜзӣёеҜ№жҜ”иҫғеҘҪзҡ„дёҖдёӘж–№жЎҲгҖӮеӣҫзҘһз»ҸзҪ‘з»ңжҠҠжҜҸдёӘз”ЁжҲ·жңүиҝҮиЎҢдёәдәӨдә’зү©е“ҒзңӢдҪңдёҖдёӘзӮ№пјҢжҠҠе…·дҪ“зҡ„иЎҢдёәзңӢдҪңиҫ№гҖӮеҰӮдёӢеӣҫжүҖзӨәпјҡ

жҺЁиҚҗйҳ…иҜ»

- еӯҰеӣҫеғҸеӨ„зҗҶжңүе“ӘдәӣдёҚй”ҷзҡ„д№ҰжҺЁиҚҗ

- еә”иҜҘжҖҺж ·зҗҶи§Јдјҡе‘ҳжңҚеҠЎзҡ„жі•еҫӢжҖ§иҙЁ

- з«ҜеҸЈеҲ°еә•жҳҜе•ҘжҰӮеҝөе’Ңipд№Ӣй—ҙжңүе•Ҙе…ізі»иғҪеҪўиұЎ+жҠҪиұЎзҡ„д»ҺжҠҖжңҜи§’еәҰжҸҸиҝ°дёҖдёӢеҗ—

- зҺӢзҘ–и“қ|еҰ»еӯҗжқҺдәҡз”·дёҙзӣҶеңЁеҚіпјҢзҺӢзҘ–и“қиҝһеӨңиө¶зҒ«иҪҰзқЎеҚ§й“әпјҢеӨҙеҸ‘еҮҢд№ұеҪўиұЎйӮӢйҒў

- иҜ»д№ҰиҜ»еҲ°3еҲҶд№ӢдёҖзҡ„ж—¶еҖҷж„ҹи§үеҫҲйҡҫзҗҶи§ЈпјҢиҰҒдёҚиҰҒ继з»ӯ

- жҖҺж ·з®ҖжҙҒеҲ°дҪҚең°и®©еӨ–еӣҪдәәзҗҶи§Јдёӯж–Үдә’иҒ”зҪ‘ж–ҮеҢ–дёӯзҡ„гҖҢеұҢдёқгҖҚгҖҒгҖҢе–·еӯҗгҖҚгҖҒгҖҢдә”жҜӣгҖҚгҖҒгҖҢж°ҙеҶӣгҖҚгҖҒгҖҢе…¬зҹҘгҖҚзӯүиҜҚ

- ActiveMQгҖҒMQTTзҡ„ж–№ејҸиҝӣиЎҢAndroidж¶ҲжҒҜжҺЁйҖҒпјҢжҲ‘зҡ„зҗҶи§ЈжҳҜеҗҰжӯЈзЎ®

- |е«ҰеЁҘдә”еҸ·еҚҮз©әпјҢжҺўжңҲIPеҪўиұЎйҰ–еҸ‘пјҢеҢ—дә¬и¶ҠйҮҺеҗ‘вҖңжҪ®зүҢвҖқиҪ¬еһӢ

- и®Іеә§|еҗҜдёңзі»з»ҹеҹ№и®ӯеё®еҠ©иҖҒеёҲе’Ң家й•ҝжӣҙеҘҪзҗҶи§Јеӯ©еӯҗ

- еҶҜз»Қеі°|еҶҜз»Қеі°еҸӨиЈ…з…§жӣқе…үпјҢзҘһжғ…иҗҺйқЎвҖңзҶҠзҢ«зңјвҖқеҗ“дәәпјҢеҪўиұЎж°”иҙЁжҡҙи·Ң