进行可扩展监督的最简单方法之一是:让语言模型编写批评意见 。如下图所示,我们让语言模型(在本例中为GPT-3.5)为短篇小说写评论 。或者,你可以做一些更复杂的事情,让类似ChatGPT的系统在对话中进行交互,要求它解释,给出细节和评论 。随着语言模型变得更加灵活,它应该能更有效地帮助您评估困难的任务 。

文章插图

所以最大的问题来了,我们如何通过实证检验这个假设?如何知道它实际上比人类更擅长发现规律,或者它确实让我们更好地评估困难任务?

我们还可以使用许多其他设置,例如 , 通过辩论实现人工智能安全:你可以训练辩论智能体 , 然后将其用作助手 。

利用随机对照实验衡量可扩展监督的效果

如何判断可扩展监督正在发挥作用呢?衡量(评估效果提升)的进展实际上非常困难 。而且我们真正感兴趣的任务是现实世界的任务 。例如,用户在 ChatGPT 中提出的最难的问题 , 也就是现实世界中的困难任务 。

此外,我们没有标准答案 。如果你想衡量在现实任务上的提升,我们将面对既困难又无法评估的任务 。所以这看起来是一个根本性的矛盾,事实上 , 我们至少可以局部性地衡量提升 。

文章插图

我认为可扩展监督之所以起作用,是因为这种评估模式比生成本身更容易 。所以对于很多任务来说,评价任务其实比把任务做好要容易得多 。这是最经典的真理 。

在计算机科学中,你会遇到NP问题 , 你可以在多项式时间内判定某个问题 , 但你不一定能生成它 。在许多其他设定场景中也是如此 。比如在体育运动中,你可以通过一支球队进球多少来判断是否获胜,但实际上要打好比赛真的很难 。在学术研究中,对优秀论文进行同行评审比提出想法并按照论文中的方式进行实验更容易 。

文章插图

我们一直在使用一种通过篡改答案实现的随机对照实验(RCT with tampered answers) 。

基本设置是,向模型输入prompt,并生成回答 。这种答案不一定是完美的,你可以篡改回答 , 通过某种方式使其变得更糟 。这样一来 , 就得到了一些有少量缺陷的回答 。

文章插图

那么在第二步中 , 就拥有了一些答案对,包括原始回答和经过篡改的回答 。之后分别利用原始回答和经过篡改的回答开始运行随机对照实验,将其展示给人类或被可扩展的监督辅助的人类 。

该任务是,让人类分辨出该回答是原始版本还是被篡改的版本,或者更复杂一点,找出具体的缺陷 。而且正是因为你篡改了回答,即使你不知道原始答案是否正确,你也知道篡改的缺陷 。这个问题既没有标准答案也没有完美的回答,但人们总是能判断出被篡改答案的版本 。事实上,理想情况下,他们每次都会发现缺陷 。

因此,通过将其随机分配给有可扩展监督协助或无协助的人,你可以通过实验说明可扩展的监督技术实际上在评估任务中对人类有多大帮助 。

此外,还可以将不同的可扩展监督技术相互比较,看看哪一种更有效 。我想在尽可能贴近真实的情况下进行实证测试 , 看看哪些技术效果最好 , 它们实际效果如何,以及如何使它们发挥作用 。

实验结果

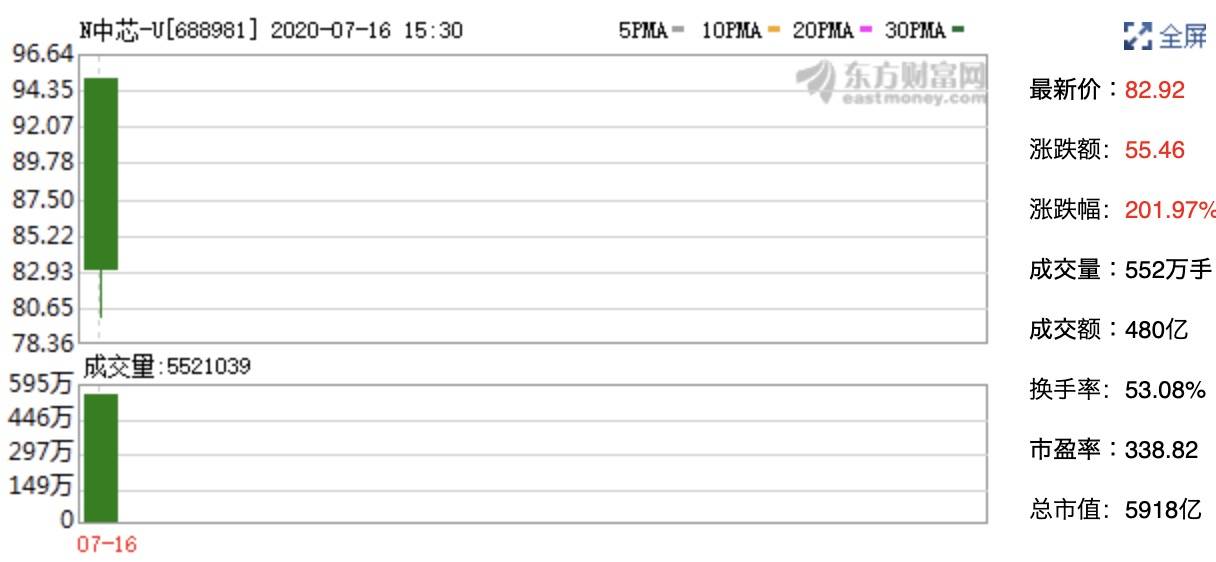

下面是GPT-3.5模型总结小说故事任务中的结果 。

实验结果表明,人类在有协助的情况下发现的缺陷比无协助的情况下多出约 50% 。事实上,通过可扩展监督,有协助的人确实在经过篡改的答案中发现了更多缺陷 。

文章插图

论文链接: https://arxiv.org/abs/2206.05802

文章插图

如何信任模型编写的代码?

下一个问题是,我们如何相信模型编写的代码?

众所周知 , GPT-4 在编写代码方面表现不错,至少如果它是相对简单的代码,或者它使用了一堆您可能不熟悉但在互联网上非常流行的库 。因此,它对于此类任务实际上非常有用 。未来的模型在代码编写方面可能会更加出色,人们会想用模型编写大量代码 。

但我们怎么知道他们实际上是在以正确的方式做这件事呢?如何判断他们的行为符合我们的意图?随着编码任务变得越复杂,实际上可能会变得越困难 。

推荐阅读

- 本命年大忌属虎怎么破解 本命年大忌属虎

- 破解冬季敏感肌肤的难题

- BBC 阻止 OpenAI 抓取数据,但对人工智能用于新闻持开放态度

- 本命年犯太岁怎么破解属兔 本命年犯太岁

- 女人桃花运旺的风水 女人桃花运旺怎么破解

- macOS窃密木马分析,你还敢轻易下载mac破解软件吗?

- 17名医生都没能诊断出的病,竟被ChatGPT破解,AI医疗的潜力有多大?

- 三碗粥破解夏日打盹

- 让食物来破解“皱”语

- 破解“人到40”的眼睛“中年危机” 爱尔眼科广东省区总院长王铮科普个性化摘镜方案