еӨ§и§„жЁЎеҲҶеёғејҸејәеҢ–еӯҰд№ еҹәзЎҖжһ¶жһ„Menger, еӨ§е№…жҸҗй«ҳзңҹе®һд»»еҠЎзҡ„еӯҰд№ ж•ҲзҺҮ

关注并жҳҹж Ү

д»ҺжӯӨдёҚиҝ·и·Ҝ

Jiangmen

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

зј–иҜ‘: T.R From: Google

ејәеҢ–еӯҰд№ з®—жі•еңЁиҝҮеҺ»еҮ е№ҙдёӯеҸ–еҫ—дәҶе·ЁеӨ§зҡ„жҲҗе°ұ гҖӮ зӣ®еүҚе…Ҳиҝӣзҡ„ејәеҢ–еӯҰд№ жЁЎеһӢеӨ§еӨҡйңҖиҰҒеӨ§йҮҸзҡ„и®Ўз®— пјҢ еӣ жӯӨдёҚд»…йңҖиҰҒеўһеҠ еңЁзҺҜеўғдёӯжҺўзҙўж”¶йӣҶж ·жң¬зҡ„иЎҢдёәдё»дҪ“зҡ„ж•°йҮҸ пјҢ иҝҳйңҖиҰҒиғҪеӨҹеңЁеәһеӨ§зҡ„и®ӯз»ғж•°жҚ®дёӢиҝӣиЎҢй«ҳж•Ҳиҝӯд»Ји®ӯз»ғзҡ„иғҪеҠӣ гҖӮ

дёәдәҶи§ЈеҶіиҝҷдёҖй—®йўҳ пјҢ з ”з©¶дәәе‘ҳжҸҗеҮәдәҶеҗҚдёәMengerзҡ„еӨ§и§„жЁЎеҲҶеёғејҸејәеҢ–еӯҰд№ жһ¶жһ„ пјҢ еҸҜд»ҘеңЁеӨҡзәҝзЁӢйӣҶзҫӨдёӯеӨ§и§„жЁЎең°е®һзҺ°ж•°еҚғдёӘиЎҢдёәеҚ•е…ғ пјҢ 并еӨ§е№…еәҰеҮҸе°Ҹд»»еҠЎзҡ„и®ӯз»ғж—¶й—ҙ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

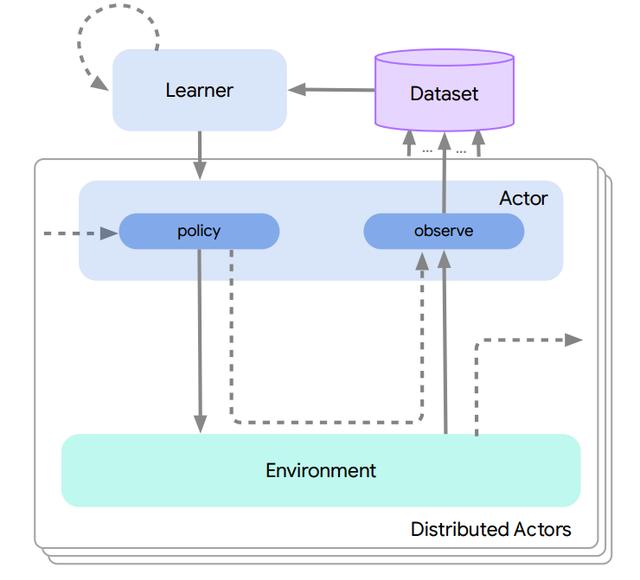

ејәеҢ–еӯҰд№ з®—жі•еңЁиҝҮеҺ»еҮ е№ҙдёӯеҸ–еҫ—дәҶе·ЁеӨ§зҡ„жҲҗе°ұ пјҢ д»ҺиҠҜзүҮеёғеұҖеҲ°иө„жәҗй…ҚзҪ® пјҢ д»ҺеӣҙжЈӢеҲ°Dota пјҢ е®ғдёҖеҫҖж— еүҚең°иҝӣжӯҘзқҖ гҖӮ з®ҖеҚ•жқҘи®І пјҢ ејәеҢ–еӯҰд№ з®—жі•зҡ„ејҖеҸ‘иҝҮзЁӢеҸҜд»Ҙи§Ҷдёәж•°жҚ®ж”¶йӣҶе’ҢжЁЎеһӢи®ӯз»ғзҡ„еҫӘзҺҜиҝҮзЁӢ пјҢ е…¶дёӯдё»дҪ“дјҡеңЁзҺҜеўғдёӯжҺўзҙўе№¶ж”¶йӣҶж ·жң¬ пјҢ иҖҢеҗҺиҝҷдәӣж•°жҚ®иў«йҖҒе…ҘеҲ°еӯҰд№ еҷЁдёӯиҝӣиЎҢи®ӯз»ғ并жӣҙж–°жЁЎеһӢ гҖӮ

зӣ®еүҚе…Ҳиҝӣзҡ„ејәеҢ–еӯҰд№ жЁЎеһӢеӨ§еӨҡйңҖиҰҒеңЁж•°зҷҫдёҮдёӘд»ҺзҺҜеўғдёӯиҺ·еҸ–зҡ„ж ·жң¬дёҠиҝӣиЎҢеӨҡж¬Ўиҝӯд»Ји®ӯз»ғеҫӘзҺҜжүҚиғҪеӨҹи§ЈеҶізү№е®ҡзҡ„зӣ®ж Үд»»еҠЎ (дҫӢеҰӮDota2зҡ„и®ӯз»ғиҝҮзЁӢжҜҸдёӨз§’е°ұиғҪеҜ№200дёҮеё§иҝӣиЎҢеӯҰд№ ) гҖӮ еңЁеҰӮжӯӨеӨ§зҡ„и®Ўз®—йңҖжұӮдёӢ пјҢ ејәеҢ–еӯҰд№ дёҚд»…йңҖиҰҒжҸҗй«ҳж•ҲзҺҮеўһеҠ еңЁзҺҜеўғдёӯжҺўзҙўж”¶йӣҶж ·жң¬зҡ„иЎҢдёәдё»дҪ“зҡ„ж•°йҮҸ пјҢ еҗҢж—¶иҝҳйңҖиҰҒиғҪеӨҹеңЁеҰӮжӯӨеәһеӨ§зҡ„и®ӯз»ғж•°жҚ®дёӢиҝӣиЎҢй«ҳж•Ҳиҝӯд»Ји®ӯз»ғзҡ„иғҪеҠӣ гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

ејәеҢ–еӯҰд№ зі»з»ҹзҡ„еҹәжң¬и®ӯз»ғжөҒзЁӢ пјҢ иЎҢдёәдё»дҪ“йҰ–е…Ҳе°ҶйҮҮйӣҶеҲ°зҡ„ж ·жң¬йҖҒеҲ°еӯҰд№ еҷЁ пјҢ иҖҢеҗҺеӯҰд№ еҷЁеҲ©з”Ёиҝҷдәӣж ·жң¬еҜ№жЁЎеһӢиҝӣиЎҢи®ӯз»ғ并е°Ҷжӣҙж–°еҗҺзҡ„жЁЎеһӢжҺЁйҖҒз»ҷиЎҢдёәдё»дҪ“ гҖӮ

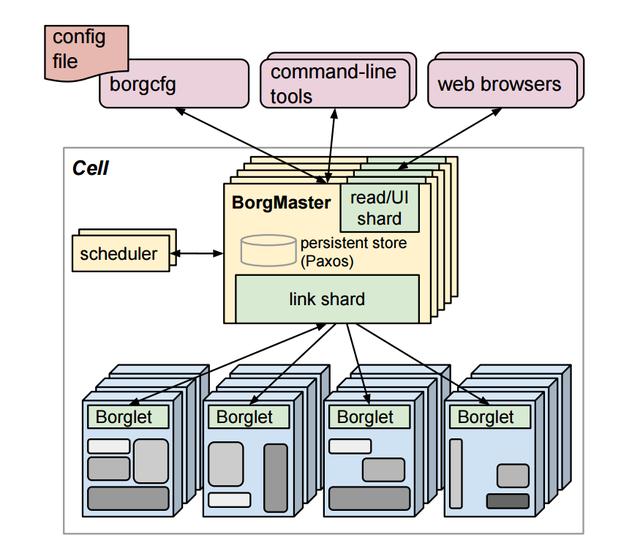

гҖҗеӨ§и§„жЁЎеҲҶеёғејҸејәеҢ–еӯҰд№ еҹәзЎҖжһ¶жһ„Menger, еӨ§е№…жҸҗй«ҳзңҹе®һд»»еҠЎзҡ„еӯҰд№ ж•ҲзҺҮгҖ‘дёәдәҶи§ЈеҶіиҝҷдёҖй—®йўҳ пјҢ з ”з©¶дәәе‘ҳжҸҗеҮәдәҶеҗҚдёәMengerзҡ„еӨ§и§„жЁЎеҲҶеёғејҸејәеҢ–еӯҰд№ жһ¶жһ„ пјҢ еҸҜд»ҘеңЁеӨҡзәҝзЁӢйӣҶзҫӨ (Borg cells) дёӯеӨ§и§„жЁЎең°е®һзҺ°ж•°еҚғдёӘиЎҢдёәеҚ•е…ғ пјҢ 并еӨ§е№…еәҰеҮҸе°Ҹд»»еҠЎзҡ„и®ӯз»ғж—¶й—ҙ гҖӮ

иҝҷзҜҮж–Үз« и®Іи§ЈдәҶж•ҙдёӘжһ¶жһ„зҡ„е®һзҺ°еҺҹзҗҶ пјҢ д»ҘеҸҠеҰӮдҪ•жҸҗй«ҳзҺ°иҠҜзүҮи®ҫи®ЎдёӯиҠҜзүҮеёғеұҖд»»еҠЎзҡ„и®ӯз»ғж•ҲзҺҮ гҖӮ е®һйӘҢиЎЁжҳҺ пјҢ иҝҷз§Қж–№жі•еҫ—еҲ°зҡ„з»“жһңзӣёиҫғдәҺеҺҹе…Ҳзҡ„ж–№жі•еҸҜд»ҘжҸҗеҚҮ8.6xзҡ„и®ӯз»ғж•ҲзҺҮ гҖӮ

жіЁйҮҠпјҡBrogзі»з»ҹжҳҜдёҖеҘ—еӨ§и§„жЁЎзҡ„йӣҶзҫӨз®ЎзҗҶзі»з»ҹ пјҢ еҸҜд»ҘеңЁж•°еҚғдёӘжңәеҷЁз»„жҲҗзҡ„еӨҡдёӘйӣҶзҫӨдёҠе®һзҺ°еҜ№дәҺдёҚеҗҢеә”з”Ёе’Ңд»»еҠЎзҡ„жңүж•Ҳз®ЎзҗҶ гҖӮ

Mengerзі»з»ҹи®ҫи®Ўдәә们еңЁеҲҶеёғејҸејәеҢ–еӯҰд№ зі»з»ҹйўҶеҹҹз ”еҸ‘еҮәдәҶдёҚеҗҢзҡ„зі»з»ҹ пјҢ еҢ…жӢ¬Acmeе’ҢSEED RLзӯү пјҢ дҪҶжҜҸз§Қзі»з»ҹйғҪй’ҲеҜ№еҲҶеёғејҸзі»з»ҹдёӯзҡ„дёҚеҗҢж–№йқўиҝӣиЎҢдјҳеҢ– гҖӮ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

ж–Үз« жҸ’еӣҫ

Acmeе’ҢSEEDзі»з»ҹ

AcmeеңЁжҜҸдёӘиЎҢеҠЁдё»дҪ“дёҠдҪҝз”ЁдәҶеұҖйғЁжҺЁзҗҶ пјҢ 并频з№Ғең°д»ҺеӯҰд№ еҷЁиҜ·жұӮжЁЎеһӢпјӣSEED RLеҲҷдҪҝз”ЁдәҶдёӯеҝғеҢ–зҡ„жҺЁзҗҶи®ҫи®Ў пјҢ еҲ©з”ЁдёҖйғЁеҲҶTPUж ёжқҘиҝӣиЎҢжү№еӨ„зҗҶ гҖӮ

дҪҶеңЁеҲҶеёғејҸејәеҢ–еӯҰд№ зі»з»ҹзҡ„и®ҫи®Ўдёӯеҝ…йЎ»иҰҒе…іжіЁдёҖдёӢдёӨдёӘйғЁеҲҶзҡ„жқғиЎЎпјҡдёҖж–№йқўжҳҜиЎҢдёәеҷЁдёҺеӯҰд№ еҷЁй—ҙзҡ„ж•°жҚ®ж ·жң¬е’ҢжЁЎеһӢдј иҫ“зҡ„йҖҡдҝЎејҖй”ҖпјӣеҸҰдёҖж–№йқўжҳҜиЎҢдёәеҷЁжң¬иә« (CPUs) зҡ„жҺЁзҗҶејҖй”ҖдёҺеҠ йҖҹеҷЁ (GPUs/TPUs) й—ҙзҡ„жҜ”иҫғ гҖӮ

еңЁз»јеҗҲиҖғиҷ‘зӣ®ж Үд»»еҠЎеҜ№дәҺи§ӮжөӢж•°йҮҸгҖҒиЎҢдёәз©әй—ҙе’ҢжЁЎеһӢеӨ§е°Ҹзҡ„жғ…еҶөдёӢ пјҢ MengerйҖүжӢ©дәҶдёҺAcmeзӣёдјјзҡ„еұҖйғЁжҺЁзҗҶж–№ејҸ пјҢ дҪҶеҚҙе°ҶиЎҢдёәеҷЁзҡ„规模иҝӣиЎҢдәҶйқһеёёеӨ§зҡ„жӢ“еұ•пјҒ

еңЁе®һзҺ°еӨ§и§„жЁЎдёҺй«ҳйҖҹи®ӯз»ғзҡ„иҝҮзЁӢдёӯ пјҢ дё»иҰҒеӯҳеңЁд»ҘдёӢдёӨдёӘжҢ‘жҲҳпјҡ

1. дёәж•°йҮҸеәһеӨ§зҡ„иЎҢдёәеҷЁжҸҗдҫӣжЁЎеһӢиҜ·жұӮжңҚеҠЎдјҡжҲҗдёәеӯҰд№ еҷЁзҡ„瓶йўҲжүҖеңЁ пјҢ йҡҸзқҖиЎҢдёәдё»дҪ“зҡ„еўһеҠ 收ж•ӣйҖҹеәҰдјҡи¶ҠжқҘи¶Ҡж…ўпјӣ

2. TPUзҡ„ж•ҲзҺҮдё»иҰҒеҸ–еҶідәҺиҫ“е…ҘжөҒзЁӢзҡ„жҖ§иғҪ пјҢ еҪ“TPUи®Ўз®—ж ёеӨ§е№…еәҰеўһеҠ ж—¶иҫ“е…ҘжөҒзЁӢзҡ„жҖ§иғҪжҳҜеҶіе®ҡж•ҙдёӘи®ӯз»ғж•ҲзҺҮзҡ„е…ій”®жүҖеңЁ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- еҫ®иҪҜEdgeжөҸи§ҲеҷЁз”ЁжҲ·е·Іиҫҫ6дәҝ е°ҶиҝҺжқҘзЁіе®ҡзүҲеӨ§и§„жЁЎжӣҙж–°

- еҪ“AIд»ҺиҷҡжӢҹиө°еҗ‘зҺ°е®һпјҡеӨ§и§„жЁЎиЎҢдёҡеә”з”ЁеҠ йҖҹ ејҖж”ҫAIе№іеҸ°жҲҗи¶ӢеҠҝ

- ж”Ҝд»ҳе®қеӨ§и§„жЁЎвҖңе°ҒеҒңвҖқеҖҹе‘—пјҢз”ЁжҲ·еҖҹй’ұжІЎиҝҳпјҢзӣҙжҺҘвҖңдёҖ笔еӢҫй”ҖвҖқдәҶпјҹ

- йҳҝйҮҢиҫҫж‘©йҷўеҸ‘еёғ2021еҚҒеӨ§з§‘жҠҖи¶ӢеҠҝпјҡ第дёүд»ЈеҚҠеҜјдҪ“жқҗж–ҷе°ҶеӨ§и§„жЁЎеә”з”Ё

- жңҖеӨ§и§„жЁЎгҖҢзңјеә•AIгҖҚзңҹе®һдё–з•Ңз ”з©¶жҲҗжһңеҸ‘еёғпјҢгҖҠBMJгҖӢеӯҗеҲҠ收еҪ•

- java д»Һйӣ¶е®һзҺ°еұһдәҺдҪ зҡ„ redis еҲҶеёғејҸй”Ғ

- еҫ®дҝЎжңӢеҸӢеңҲе№ҝе‘ҠдёҚиғҪе…ій—ӯиў«зӮ№еҗҚ е®ҳж–№еӣһеә”пјҡејәеҢ–е№ҝе‘Ҡе®Ўж ё

- зҷҫеәҰең°еӣҫдёҺзҷҫеәҰзҲұдјҒжҹҘжү“йҖҡж•°жҚ®пјҡејәеҢ–дјҒдёҡPOIеҜҢеҶ…е®№пјҢеҚҮзә§дёҖз«ҷејҸдҝЎжҒҜжҗңзҙўдҪ“йӘҢ

- HarmonyOS 2.0жүӢжңәејҖеҸ‘иҖ…BetaзүҲзңҹжқҘдәҶпјҒеҝ«жқҘеҚҮзә§EMUI11жҸҗеүҚж„ҹеҸ—еҲҶеёғејҸжҠҖжңҜ

- еӣӣж ёејәжҖ§иғҪпјҢеҚҺзЎ•XD4зҒөиҖҖAXйӯ”ж–№еҲҶеёғејҸи·Ҝз”ұиҜ„жөӢ