那年初夏|华人学者提出软件算法架构加速AI实时化,性能超越GPU、FPGA( 二 )

此外 , 能够方便快捷的使用AI应用也是至关重要的一环 , 由于移动支付的普及 , 很多人出门连钱包都省了 , 只带一个手机 。 显然 , 随身携带GPU或FPGA硬件加速器是不现实的 。 所以无论从公司的角度还是大众的角度来说 , 基于软件和通用计算设备(比如手机)的AI加速无疑是AI应用的最佳选择 。

那么我们不禁要问:

1.我们能否在没有特殊硬件加速器的普通手机(或其他边缘设备)上 , 克服高算力需求 , 将各种AI应用实时化呢?

2.如果真的可以 , 那么与专用硬件加速器相比 , 基于软件优化和普通手机的实现方式性能又如何呢?能不能比硬件加速器跑的还快 , 能量效率还高呢?

答案是肯定的 。

近期 , 由美国东北大学王言治研究组、威廉玛丽学院任彬研究组和北卡州立大学慎熙鹏研究组共同提出了名为CoCoPIE的软件算法架构 , 通过有效的“压缩-编译”协同设计(compression-compilationco-design) , 在没有特殊硬件加速器的情况下 , 使用现有边缘设备(如智能手机) , 依然可以实现人工智能的实时化 , 并且在性能上超越了特殊硬件加速器 。

他们还坚信 , AI应用程序的软件优化潜力仍未得到充分开发 , 即使在移动AI时代 , 软件仍然将占有业界的主导地位 。 一旦我们可以在数十亿现有的移动设备上启用实时AI , 那么一个拥有万亿美元的庞大市场将被彻底释放 。

他们将CoCoPIE架构在三星GalaxyS10智能手机上的性能和基于ASIC和FPGA的硬件机器学习加速器的性能进行了对比 。

结果显示CoCoPIE在能效方面始终优于这些代表性的ASIC/FPGA解决方案 。 这种独特的现象归因于三个原因:

1.智能手机本身具有超高的能量效率 。 智能手机芯片使用最先进的技术(例如7nm , 11nm技术)构建;而FPGA/ASIC解决方案则基于28nm或40nm技术--这些技术本身节能效果较差 。 同样 , ARM(移动CPU)和高通(移动GPU)尤其擅长高效电路/系统设计 。 CoCoPIE可以最大限度地利用这些前人的成果 。

2.虽然现有的移动编译器框架对不同神经网络的支持有限(例如 , 不支持RNN或大规模DNN) , 但CoCoPIE可以支持所有的主流神经网络 , 从而释放了移动设备的全部潜力 。

3.由于基于软件的解决方案具有高度的灵活性 , 因此CoCoPIE在不同的DNN上始终保持高性能 。 相反 , 当前的ASIC/FPGA解决方案通常针对特定的DNN类型/大小进行优化 , 从而影响其通用性 。 具体而言 , 边缘TPU通常针对小型DNN优化 , 而云端TPU通常针对大型DNN优化 。

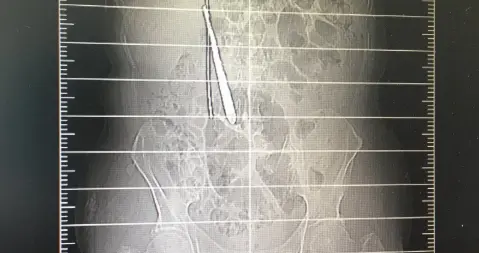

他们利用CoCoPIE框架在一台普通的三星GalaxyS10手机上实现了多种具有代表性的AI应用 , 并成功地做到了可实时 。 比如图2所示的风格转换 , 视频上色以及超分辨率应用全部达到了实时运行标准(每秒不小于30帧) 。 此外 , 他们还在手机上成功实现了更具挑战性的AI应用 , 包括基于YOLO-V4的物体检测 , 以及基于3D卷积的行为识别 , 并且分别达到了14帧每秒和110帧每秒 , 如图3所示 。 更多的演示视频请参考下面的网址 。

Youtube:

B站:

;seid=13333469485394270447

推荐阅读

- 那年初夏|SecMind近期安全资讯第十九期

- 春公子|一念之差失败破产,他是昔日华人首富:一人之力挑战美国科技巨头

- 硅谷|欢迎回家!在美华人经历至暗时刻,硅谷上万华人工程师毅然离开

- 科技小辛辛|这篇CVPR华人论文帮你搞定,手残党福音:一键抠图、隔空移物

- 风抚那年殇|其中有四件在中国, 个个都是价值连城,世界上5大失传文物,

- 华为|华为被制裁是自找的?美籍华人院士再放狠话:不要老说自己是第一!

- 那年初夏|转网后遗症?,只出不进?中国移动今年累计流失用户近400w

- 那年初夏|国家出手统筹规划,为发展助力,全国一心的时代要到了

- 那年初夏|19种多彩混光让你酷炫吃鸡,百元性价比机械键盘推荐

- IBM|最悲壮的华人首富:曾经的世界电脑大王,为什么会轰然倒下?