谷歌用算力爆了一篇论文,解答有关无限宽度网络的一切( 二 )

最后 , 研究者比较了两种参数化网络权重和偏置的方法:标准参数化(STD)和 NTK 参数化(NTK) 。 其中 STD 用于有限宽度网络的研究 , NTK 则在目前大多数无限宽度网络研究中得到应用 。

除非另有说明 , 该研究中所有核方法的实验都是基于对角核正则化(diagonal kernel regularization)独立优化完成的 。 有限宽度网络则全都使用了与 base 模型相对应的小学习率 。

这篇论文中的实验基本都是计算密集型的 。 举个例子 , 要为 CNN-GAP 架构在 CIFAR-10 上计算 NTK 或 NNGP , 就必须用 6×10^7 乘 6×10^7 的核矩阵对各项进行评估 。 通常来说 , 这需要双精度 GPU 时间约 1200 小时 , 因此研究者使用了基于 beam 的大规模分布式计算基础设施 。

所有实验都使用了基于 JAX 的 Neural Tangents 库:https://github.com/google/neural-tangents 。

为了尽可能地做到系统性 , 同时又考虑到如此巨大的计算需求 , 于是研究者仅使用了一个数据集 CIFAR-10 , 即在该数据集上评估对每种架构的每种修改措施 。 同时 , 为了保证结果也适用于不同的数据集 , 研究者还在 CIFAR-100 和 Fashion-MNIST 上评估了部分关键结果 。

从实验中得到的 12 条结论

以下为基于实验结果总结的 12 个结论(详细分析请参阅原论文):

1. NNGP/NTK 的表现可胜过有限网络

在无限网络研究中 , 一个常见假设是它们在大数据环境中的表现赶不上对应的有限网络 。 通过比较核方法与有限宽度架构(使用小学习率 , 无正则化)的 base 模型 , 并逐一验证可打破(大学习率、L2 正则化)或改进(集成)无限宽度与核方法对应性的训练实践的效果 , 研究者验证了这一假设 。 结果见下图 1:

本文插图

图 1:有限和无限网络及其变体在 CIFAR-10 上的测试准确率 。 从给定架构类别的有限宽度 base 网络开始 , 标准和 NTK 参数化的模型表现随着修改而发生变化:+C 指居中(Centering)、+LR 指大学习率、+U 指通过早停实现欠拟合、+ZCA 指使用 ZCA 正则化进行输入预处理、+Ens 指多个初始化集成 , 另外还有一些组合方案 。 Lin 指线性化 base 网络的性能 。

从中可以观察到 , 对于 base 有限网络 , 无限 FCN 和 CNN-VEC 的表现要优于它们各自对应的有限网络 。 另一方面 , 无限 CNN-GAP 网络的表现又比其对应的有限版本差 。 研究者指出这其实与架构有关 。 举例来说 , 即使有限宽度 FCN 网络组合了高学习率、L2 和欠拟合等多种不同技巧 , 无限 FCN 网络的性能还是更优 。 只有再加上集成之后 , 有限网络的性能才能达到相近程度 。

另一个有趣的观察是 , ZCA 正则化预处理能显著提升 CNN-GAP 核的表现 。

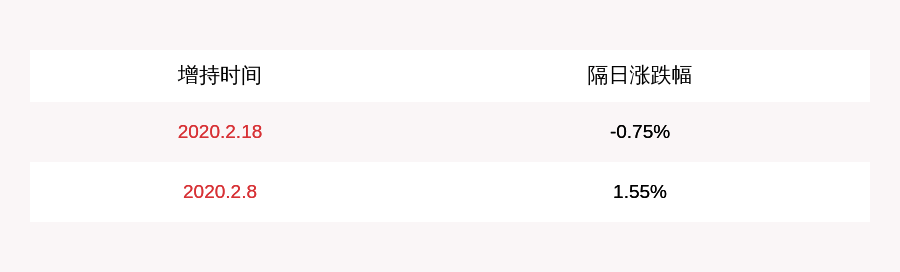

2. NNGP 通常优于 NTK

从下图 2 中可以看出 , 在 CIFAR-10、CIFAR-100 和 Fashion-MNIST 数据集上 NNGP 的性能持续优于 NTK 。 NNGP 核不仅能得到更强的模型 , 而且所需的内存和计算量也仅有对应的 NTK 的一半左右 , 而且某些性能最高的核根本就没有对应的 NTK 版本 。

本文插图

图 2:当对角正则化经过精心调整时 , NNGP 在图像分类任务上通常优于 NTK 。

3. 居中和集成有限网络都会得到类 kernel 的表现

本文插图

图 3:居中可以加速训练和提升性能 。

本文插图

图 4:集成 base 网络可让它们达到与核方法相媲美的表现 , 并且在非线性 CNN 上还优于核方法 。

推荐阅读

- 中年|谷歌生草机,翻译《我的世界》20变,连亲妈都不认识

- 印度|又爆了!印度新增确诊连创纪录!一夜间超巴西?美国地位不保?

- 特朗普-奥巴马|特朗普有多恨奥巴马,前律师出书爆了这样一个猛料

- "老公"又出手!王思聪带女生现身楼盘看房 这个楼盘爆了!

- 穿搭|简直美爆了 我全部都要

- 蹴鞠小子|三连胜,瓦基弗银行再次零封对手;状态爆了,哈克打出超神数据!

- 暮年|谷歌结合物理模拟与机器学习方法,改进洪水预测速度与准确度

- 笑爆了i|我是深有体会.,搞笑段子:对于学好一门知识的重要性

- 适应生活|程序员用香蕉玩街机游戏,潮爆了!杭州云栖大会极客派

- 王霏霏|迪丽热巴高伟光要捆绑?王霏霏出道位被抢?成毅爆了?乐华七子貌合神离?薇娅翻车?